去中心化分布式机器学习(Decentralized Distributed Machine Learning)已成为大规模机器学习,尤其是大模型时代处理数据、模型训练、推理的重要范式。但在现实去中心化的应用场景(例如:自动驾驶,无人机群,电网无人巡检等)中充分利用多个分散设备来进行去中心化的机器学习和模型训练仍然具有挑战性,特别是基于传统线性聚合框架来解决全局机器学习模型收敛性是一个巨大的挑战,主要存在以下两个问题:非独立同分布数据异构性和时变通信链路问题。数据异构性是分布式机器学习训练的关键挑战之一,异构设备上非独立同分布数据的导致模型发散和收敛缓慢,并影响模型泛化性。随着时间动态变化的通信链路更是加剧了去中心化分布式机器学习训练过程的聚合难度,从而是每一轮的模型聚合具有很强的不确定性,从而导致整个模型训练收敛速度慢,甚至整个训练失败的情况。因此,有必要从全面的角度考虑数据异构性和时变通信链路,以提高去中心化分布式机器学习在现实世界中的应用性能。

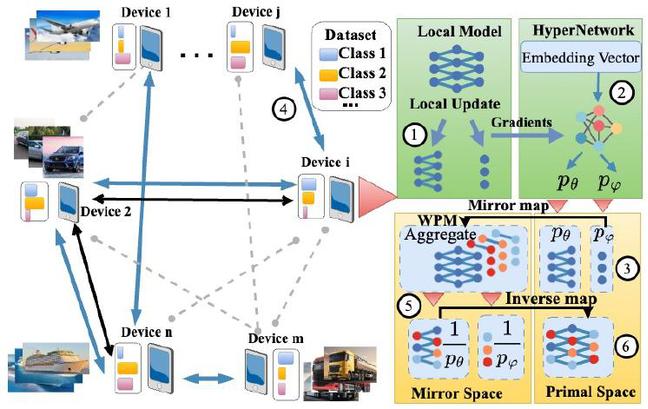

为此,团队提出提出了一个非线性类聚合框架HyperPrism,它利用分布式镜像下降,在镜像下降对偶空间中进行聚合,并适应每轮使用的加权权重。此外,HyperPrism可以通过每个设备的专用超网络,自适应地选择本地模型不同层的不同镜像空间映射,实现高维度空间下去中心化分布式机器学习的自动优化。团队通过严格的数学分析和实验评估,证明了自适应镜像映射分布式机器学习的有效性。同时团队将结论泛化扩展到现有的模型线性聚合工作中,并将传统线性聚合方式变为HyperPrism中的一类特殊案例。

图1 HyperPrism框架整体架构概览

最后实验结果表明,与最先进的技术相比,HyperPrism可以将加速整个模型收敛速度提升98.63%,并且具有良好的模型可扩展性,可以很好地扩展到更多的设备,与传统的线性聚合相比,所有这些非线形聚合操作都没有增加额外的计算开销。这些成果都将对未来的基于车联网的自动驾驶,大规模电力无人巡检,大模型时代的模型分布式训练、推理应用产生重要影响,加速其应用落地。

该论文成果的其他合作者包括美国麻省理工学院和上海交通大学。该论文的发表代表了上海电力大学能源大数据智慧计算团队在分布式机器学习这一国际科技前沿领域的研究处于引领地位。

计算机学院杜海舟 供稿